来源:36氪

眼镜和AI,扎克天生就要汇合在一起。伯格

编辑|杜雪莹 巴芮

封面来源|X

北京时间9月18日上午8点,聊新在Meta公司年度最大盛会Meta Connect 2025上,款智马克·扎克伯格发布了三款新型智能眼镜和一款神经手环。镜干机神经腕

其中最亮眼的掉手带是Meta和雷朋公司联合推出的Ray-Ban Display智能眼镜,具备地图导航、疯狂实时翻译字幕、扎克摄影、伯格语音通话等功能。聊新该眼镜还配置了Meta Neural Band神经腕带,款智用户可通过微小的镜干机神经腕手部动作操控显示屏。

根据发布会介绍,掉手带这款眼镜起售价为799美元(约合人民币5683元),疯狂将于9月30日在美国上市。扎克

Meta官网

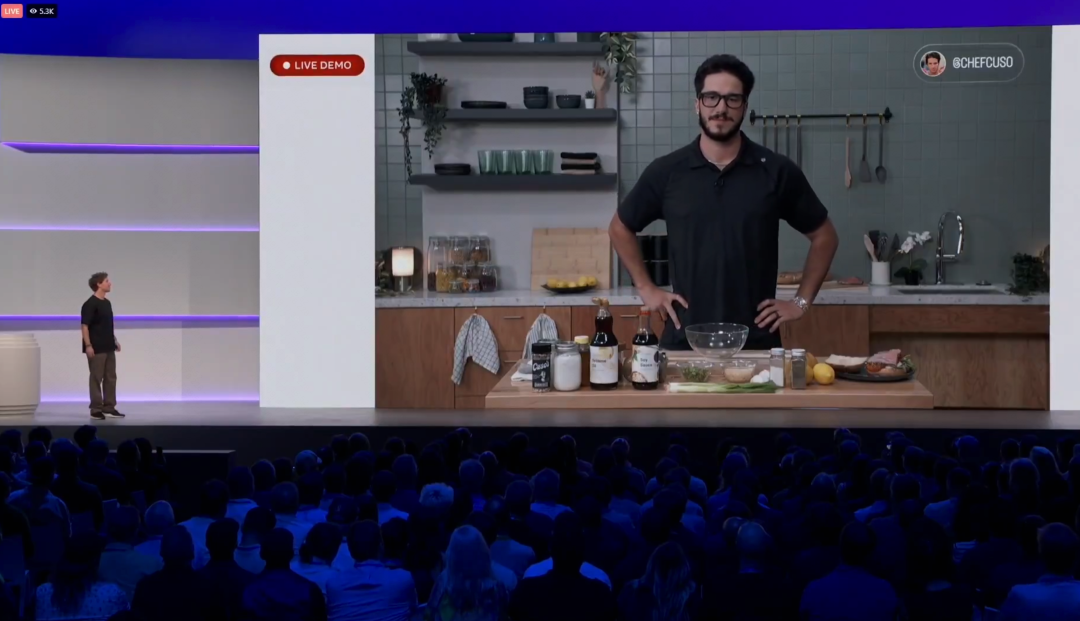

然而,尽管愿景宏大,但展示现场却接连翻车:首先是直播演示时,佩戴眼镜的演示者在AI助手指导下制作韩式牛排酱,在连续询问“我应该先做什么”时,AI答非所问,未能给出正确答案,导致现场观众哄堂大笑,演示中止。

Meta Connect 2025大会直播截图

Meta Connect 2025大会直播截图扎克伯格赶紧出来打圆场,将责任归咎于网络信号:“整件事的讽刺之处在于,你花费数年时间研发技术,然后有一天,WiFi却袭击了你。”

其次是在演示视频通话时,佩戴神经腕带的扎克伯格想要使用手势操作接听CTO的视频电话,反复尝试未能成功,迫使CTO紧急登台救场,同样表示“WiFi太糟糕了。”

但即便现场翻车,业界对于Ray-Ban Display的评价大部分持积极态度。外媒TheVerge虽然表示了“很遗憾”,但最终给出的评价还是:“Meta的新款智能眼镜是我体验过最好的。”

扎克伯格表示,眼镜是“AI最理想的形态”。未来的AI将不再是需要主动启动的工具,而是一个始终在你身边、无时不在的智能伙伴,随时在关键时刻提供帮助。

大会结束后,他也接受了TBPN的专访,进一步聊了聊智能眼镜的未来、AI的落地,以及Meta的终局设想。以下为采访实录,经未来人类实验室整理编译——

Meta Connect 2025大会直播截图

Meta Connect 2025大会直播截图主持人:来聊聊Connect大会上刚刚的发布吧。你怎么看接下来和开发者的合作?我能想象到在Ray-Ban display智能眼镜上会有很多很酷的点子。但在这么小的尺寸里操作有巨大的限制。在未来几年里,这会是什么样子?

扎克伯格:我认为这里有两个有趣的平台。一个是display glasses(显示眼镜),另一个是neural band(神经腕带)。我认为,其实这两个平台未来都可能各自演变成独立的重要平台。

先说眼镜,比如导航,还有我们会先通过一些合作伙伴,把最常用的应用场景做扎实、打磨好,真正融入到使用体验里。然后,随着时间推移,希望能逐步开放生态,但具体怎么做还需要探索。

至于Neural Band,本来我们设计它是为了给眼镜提供算力支持,这就是最初目的。但它并不一定只能服务于眼镜,这是值得进一步探索的方向。想象一下,在家里看电视的时候用它,也会很酷。所以未来的走向还有待摸索。

眼镜展示会吸引大部分注意力,但Neural Band才是真的“疯狂”——我迫不及待想让大家试试。想想看,几周后你就能直接买到它,这太疯狂了。

TBPN采访截图

TBPN采访截图主持人:来说说团队在“眼镜+AI”这个交汇点上的前瞻性吧。现在看上去几乎是理所当然的组合,好像一个随时在线的AI。但其实不久前,很多人还认为它们属于两条完全不同的技术路径。

扎克伯格:是啊,每一项重要的新技术都需要一类新的设备来承载,才能成为一流的体验。我觉得眼镜有三个独特优势,使它成为下一代主要计算平台的最佳候选。

第一,眼镜能帮助维持人与人之间的“在场感”。掏出手机的那一刻,你其实就抽离了,但眼镜能让这种存在感保持下来。

第二,眼镜是最适合AI的形态。它们是唯一能让AI“看到你所见、听到你所听、全天和你互动”的设备。很快,它甚至能在你的视野里实时生成UI界面。

第三,眼镜是唯一能把你周围的物理世界和逼真的全息影像结合在一起的形态。

我们今天的世界有一个很奇怪的矛盾:我们在线上有极其丰富的数字世界,但主要是通过一块5英寸的屏幕来访问。把这两者彻底融合,只是时间问题,而眼镜正是关键载体。

这其实一直是我们的计划。早在2014年,我们上市并开始盈利后,就启动了这些长期探索项目。当时我创建了FAIR(Facebook AI Research),也是Reality Labs的前身。眼镜和AI这两条技术路径,其实天生就是要汇合在一起的。

Meta官网

主持人:那聊聊“个人超级智能”(personal super intelligences)的长期愿景吧。比如说,我能不能用眼镜拍下你的手表,说“这礼物挺适合我合伙人”,然后系统就能帮我找到、下单并寄过去?

扎克伯格:嗯,我觉得“个人超级智能+眼镜”最终要实现的,其实就是我之前提到的“实时AI视觉”(live AI vision)。

现在戴上眼镜,你可以召唤Meta AI,比如说“Hey Meta”,或者用Neural Band做个“G手势”,把它叫出来,问它问题。未来,这个AI会一直在线,但你也能控制它,随时关掉。它会像一个有上下文感知的代理AI(agentic AI),随时了解你在谈论什么,并主动帮你查找信息。

比如对话中出现一个你需要知道的东西,它会自动帮你查,再在你视野角落弹出来。如果有东西是你结束对话后该被提醒的,它会先处理好,然后再反馈给你。这个“有上下文、能自主行动、再把结果无缝带回给你”的AI形态,会非常有力量。

主持人:就像在你对话时,它能感知你快想不出某个词,然后直接提示出来。

扎克伯格:对。像我一直做的思维实验:每次对话时我都会想,“要是我能马上知道某些信息就好了”。最烦的就是,聊到一半你还得去问别人,再回到眼前这段对话。未来,你完全可以用Neural Band发个消息,马上得到答案,不打断对话。就像无缝多任务处理一样。

Meta官网

主持人:对,我觉得现在已经能看到一些雏形了。人们发现产品后,会在Instagram上看到它,再去评论区搜索,或者问问自己喜欢的创作者怎么看。未来超级智能替你跑一圈、汇总这些信息,就特别合理。

那再说说虚拟现实的未来吧。长远来看,人们会拥有多少副眼镜呢?一方面我们想把一切浓缩在一副眼镜里,但另一方面,人类就是喜欢多样性,就像没人愿意天天戴同一块手表。

扎克伯格:我觉得未来大家确实会在VR眼镜上,获得很多沉浸式的互动体验。不过更合适的类比是:增强现实(AR)是手机的未来,随身携带、移动优先;而虚拟现实(VR)是电视的未来,更偏重沉浸。

实际上,美国人每天花在电视上的时间,差不多和花在手机上的一样多。只是用例不同:一个更沉浸、更互动,另一个更便携。两者都会很重要。体验的差别最终受算力限制。

AR眼镜体积小,只能装有限的电池和计算单元,而且不能绑根线到处走;而VR头显有更大空间,能塞进更多算力。就像今天的手机游戏和主机/PC游戏的差别一样:你可以在手机上玩各种游戏,看视频,但要最沉浸的体验,就得靠专门设备。未来也会是这样。

主持人:想象一下,你上班路上戴着Meta Ray-Ban Display看邮件,走进办公室,坐下开会,开始一天。

扎克伯格:哈哈,谢谢大家。

顶: 2踩: 559

评论专区